- 8.8/10 (12 Reviews)

- 4 bulan lalu

NVIDIA meluncurkan Spark, superkomputer AI personal yang membawa kemampuan AI tingkat data center ke rumah. Simak fitur dan spesifikasinya.

Konsep melatih kecerdasan buatan (AI) menggunakan data yang dihasilkan oleh AI lain mungkin terdengar absurd, namun kini gagasan tersebut semakin populer dan banyak dieksplorasi karena data asli semakin sulit didapatkan.

Perusahaan seperti Anthropic, Meta, bahkan OpenAI sudah mulai menggunakan data sintetis untuk melatih model AI mereka. Anthropic menggunakan data sintetis untuk melatih Claude 3.5 Sonnet, Meta menggunakan data buatan untuk fine-tuning Llama 3.1, dan OpenAI dikabarkan mengambil data sintetis dari model "reasoning" mereka, o1, untuk Orion.

Sistem AI pada dasarnya adalah mesin statistik yang mempelajari dan mengidentifikasi pola dalam data. Proses ini sangat bergantung pada anotasi data, yaitu proses pemberian label dan makna pada data mentah.

Misalnya, dalam sebuah foto dapur, anotasi "dapur" akan membantu AI mengasosiasikan gambar tersebut dengan ciri-ciri dapur, seperti kulkas dan meja dapur. Jika foto dapur dilabeli dengan kata "sapi," maka AI akan menganggap dapur sebagai sapi.

Hal tersebut menunjukkan anotasi yang akurat memungkinkan model AI untuk memahami konteks, membedakan antara berbagai konsep, dan meningkatkan kemampuan prediktifnya.

Karena pentingnya anotasi ini, pasar jasa anotasi data telah mengalami pertumbuhan yang signifikan, namun ironisnya, banyak pekerja di sektor ini, terutama di negara-negara berkembang, masih berjuang dengan upah rendah dan kondisi kerja yang tidak layak.

Situasi ini memunculkan pertanyaan etis tentang tanggung jawab perusahaan teknologi terhadap tenaga kerja yang mendukung perkembangan AI.

Ketersediaan data asli yang berkualitas semakin menjadi isu krusial bagi kemajuan AI. Pemilik data semakin enggan memberikan akses karena kekhawatiran tentang penyalahgunaan, plagiarisme, dan kurangnya kompensasi yang adil.

Lebih dari 35% situs web terkemuka dunia telah memblokir web scraper milik OpenAI, dan sekitar 25% data dari “sumber berkualitas tinggi” juga dibatasi. Epoch AI memproyeksikan bahwa para pengembang AI akan kehabisan data untuk melatih model generatif antara tahun 2026 dan 2032 jika tren ini terus berlanjut.

Data sintetis hadir sebagai alternatif yang menawarkan kemungkinan untuk menciptakan data baru dari sedikit data awal. Perusahaan teknologi seperti Writer telah mengimplementasikannya dengan model Palmyra X 004 yang dilatih hampir sepenuhnya dengan data sintetis.

Selain itu, Perusahaan lain juga mulai mengeksplore teknologi ini, seperti Microsoft, dengan model Phi-nya, Google dengan model Gemma yang ringan, dan Nvidia, dengan model khusus untuk menghasilkan data sintetis.

Perusahaan-perusahaan tersebut telah menginvestasikan sumber daya yang besar dalam pengembangan teknologi ini. Gartner memprediksi bahwa 60% data untuk proyek AI pada tahun 2024 akan dihasilkan secara sintetis, menunjukkan bahwa data sintetis bukan lagi sekadar konsep teoritis, tetapi telah menjadi bagian integral dari strategi pengembangan AI.

Meskipun menjanjikan, data sintetis tidak terlepas dari risiko dan keterbatasan. Salah satu kekhawatiran utama adalah potensi bias dalam data sintetis.

Jika model yang menghasilkan data sintetis memiliki bias, maka bias tersebut akan tercermin dalam data yang dihasilkan, dan kemudian akan memperkuat ketidaksetaraan yang sudah ada dalam data asli.

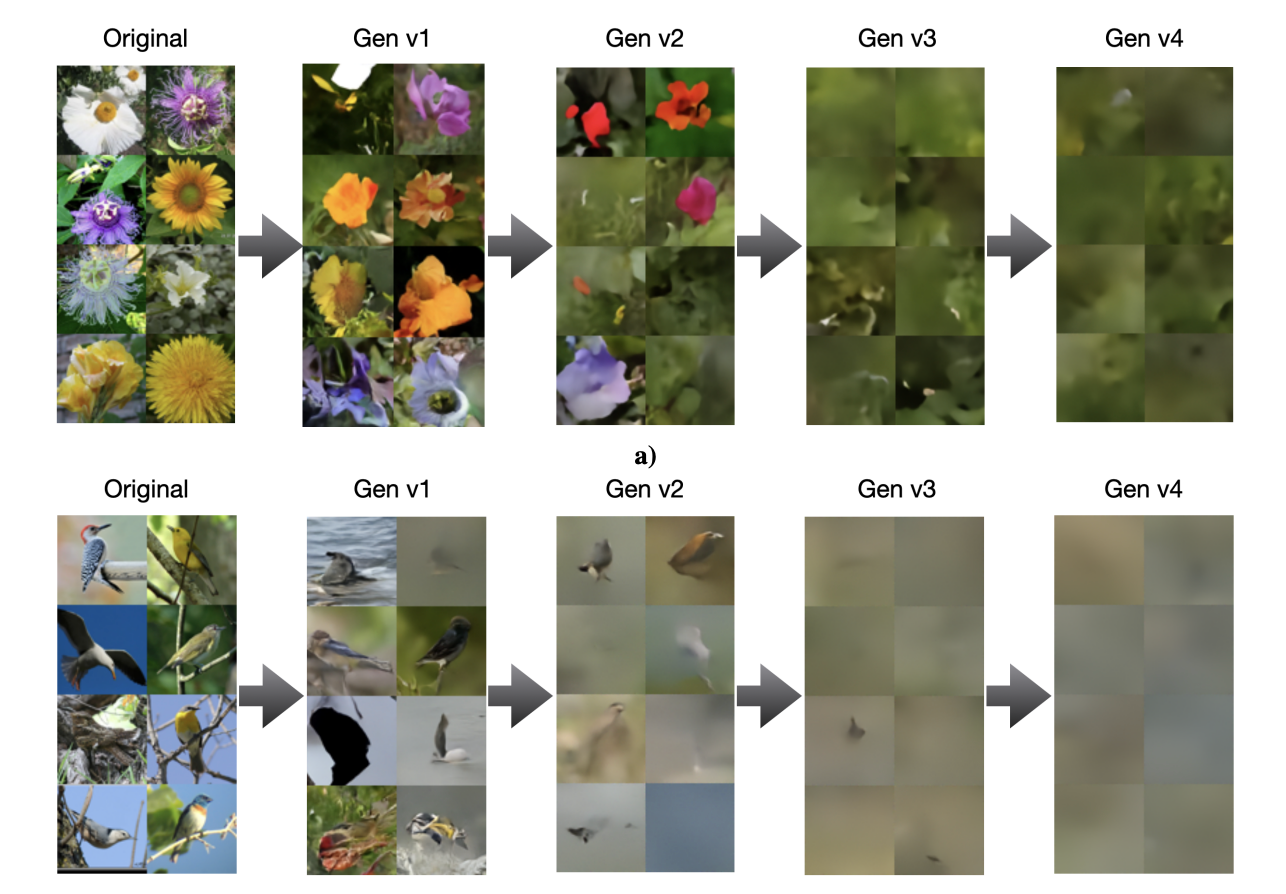

Penelitian dari Rice University dan Stanford menunjukkan bahwa ketergantungan pada data sintetis dapat menurunkan kualitas dan keragaman model AI seiring waktu. Selain itu, ada risiko halusinasi dalam data sintetis, terutama yang dihasilkan oleh model kompleks seperti model reasoning o1 milik OpenAI, yang dapat mempengaruhi akurasi model yang dilatih.

Hal tersebut tidak berlaku hanya untuk model “text-generation” saja, melainkan untuk model lain, seperti model Image generation. Sebuah studi oleh Ilia Shumailov membuktikan hal tersebut:

Sam Altman, CEO OpenAI, pernah mengungkapkan visinya bahwa AI suatu saat akan mampu menghasilkan data sintetis yang cukup berkualitas untuk melatih dirinya sendiri. Namun, teknologi tersebut masih dalam tahap awal dan belum terbukti secara praktis.

Untuk saat ini, manusia masih memainkan peran penting dalam memastikan kualitas, akurasi, dan etika dalam pelatihan model AI. Data sintetis menawarkan potensi yang besar untuk mengatasi tantangan ketersediaan data, tetapi juga menimbulkan pertanyaan etis dan praktis yang perlu dipertimbangkan dengan cermat.

Masa depan AI yang berkelanjutan mungkin terletak pada keseimbangan antara data asli, data sintetis, dan keterlibatan para ahli.